Conçu pour faciliter l’intégration de l’IA dans les applications des développeurs, Gemma 3 excelle dans la génération de texte, l’analyse d’images et le traitement de vastes quantités de données, tout en restant adaptable et optimisé pour différentes infrastructures. Ce nouveau modèle introduit plusieurs avancées notables :

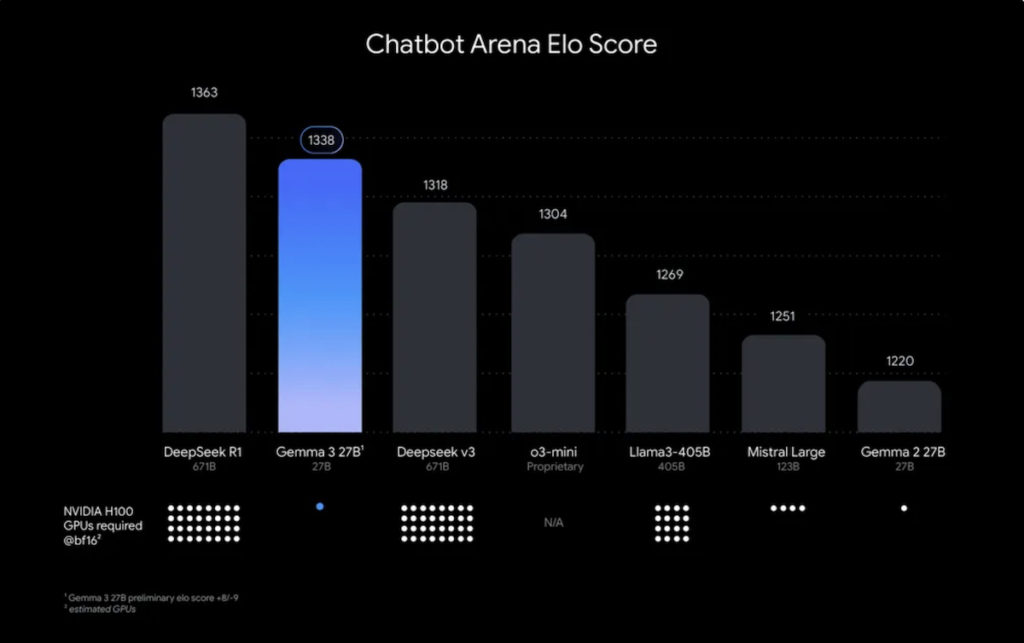

Performances accrues : surpassant des modèles concurrents comme Llama-3 8B, DeepSeek-V3 et o3-mini, il offre une puissance de calcul optimisée pour fonctionner efficacement sur une seule unité GPU ou TPU.

Prise en charge multilingue : avec la compatibilité de plus de 140 langues, il s’adapte aux projets internationaux.

Capacité multimodale : capable d’interpréter du texte, des images et même de courtes vidéos, il ouvre de nouvelles perspectives pour des applications interactives et intelligentes.

Fenêtre de contexte étendue : grâce à ses 128 000 tokens, il peut traiter des documents longs et fournir des réponses plus précises sur des sujets complexes.

Appels de fonctions intégrés : facilitant l’automatisation et l’interaction dynamique, il prend en charge les outputs structurés pour une meilleure intégration dans les workflows.

Optimisation du déploiement : Google propose des versions quantifiées du modèle, réduisant les ressources nécessaires sans compromettre les performances.